개별 데이터 항목은 ' 텐서 ' PyTorch에서는 ' 그라데이션 ” 텐서는 딥 러닝 모델의 훈련 루프 내에서 역방향 전파를 사용하여 계산됩니다. 용어 ' 크기가 조정되지 않은 ”는 데이터가 원시 데이터이며 전처리나 최적화가 포함되지 않았음을 의미합니다. Tensor의 스케일되지 않은 그래디언트는 지정된 손실 함수에 대한 실제 변화 값을 제공합니다.

이 블로그에서는 PyTorch에서 Tensor의 스케일되지 않은 그래디언트를 계산하는 방법에 대해 설명합니다.

PyTorch에서 Tensor의 Unscaled Gradient란 무엇입니까?

Tensor는 데이터를 포함하고 PyTorch의 GPU에서 실행될 수 있는 다차원 배열입니다. 전처리, 변환 또는 최적화 없이 데이터 세트의 원시 데이터를 포함하는 텐서를 스케일링되지 않은 텐서라고 합니다. 그러나 “ 크기 조정되지 않은 그라디언트 ”는 스케일링되지 않은 텐서와 다르므로 둘을 혼동하지 않도록 주의해야 합니다. 텐서의 스케일링되지 않은 그래디언트는 선택된 손실 함수에 대해 계산되며 더 이상 최적화나 스케일링이 없습니다.

PyTorch에서 텐서의 스케일되지 않은 그라디언트를 계산하는 방법은 무엇입니까?

텐서의 스케일되지 않은 그래디언트는 선택된 손실 함수와 관련된 입력 데이터 변화율의 실제 값입니다. 원시 그래디언트 데이터는 훈련 루프 동안 모델의 동작과 진행 상황을 이해하는 데 중요합니다.

PyTorch에서 텐서의 스케일되지 않은 그래디언트를 계산하는 방법을 알아보려면 아래 단계를 따르십시오.

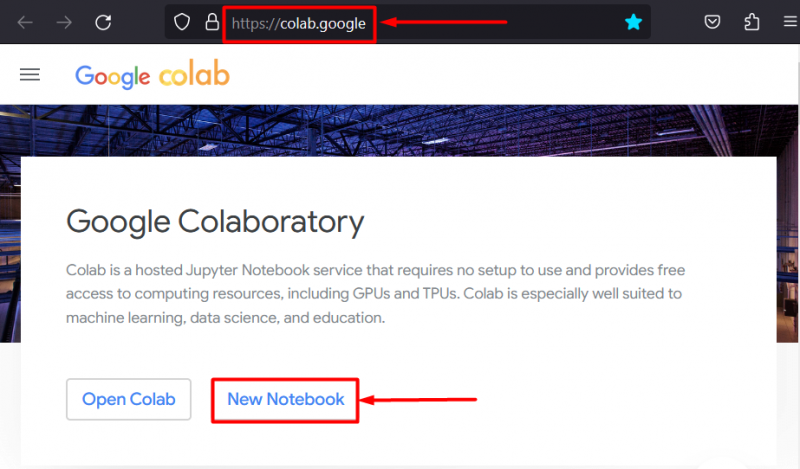

1단계: IDE를 설정하여 프로젝트 시작

Google Colaboratory IDE는 더 빠른 처리를 위해 GPU에 대한 무료 액세스를 제공하므로 PyTorch 프로젝트 개발을 위한 최선의 선택 중 하나입니다. Colab으로 이동 웹사이트 그리고 “를 클릭하세요. 새 노트북 ” 작업 시작 옵션:

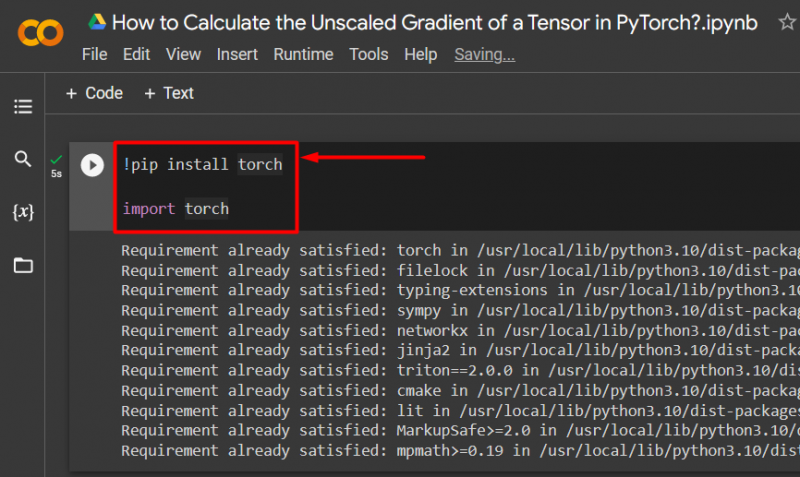

2단계: 필수 Torch 라이브러리 가져오기

PyTorch 프레임워크의 모든 기능은 ' 토치 ' 도서관. 모든 PyTorch 프로젝트는 다음 라이브러리를 설치하고 가져오는 것으로 시작됩니다.

!pip 설치 토치수입 토치

위 코드는 다음과 같이 작동합니다.

- “! 씨 ”는 프로젝트에 라이브러리를 설치하는 데 사용되는 Python용 설치 패키지입니다.

- “ 수입 ” 명령은 설치된 라이브러리를 프로젝트에 호출하는 데 사용됩니다.

- 이 프로젝트에는 ' 토치 ' 도서관:

3단계: 그라데이션을 사용하여 PyTorch Tensor 정의

사용 ' 토치.텐서 ()” 그래디언트로 텐서를 정의하는 방법 “ require_grad=참 ' 방법:

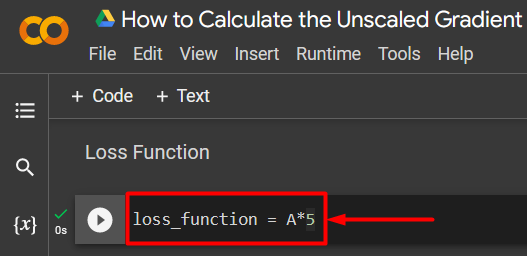

A = torch.tensor([5.0], require_grad=True)4단계: 단순 손실 함수 정의

손실 함수는 다음과 같이 간단한 산술 방정식을 사용하여 정의됩니다.

loss_function = A*5

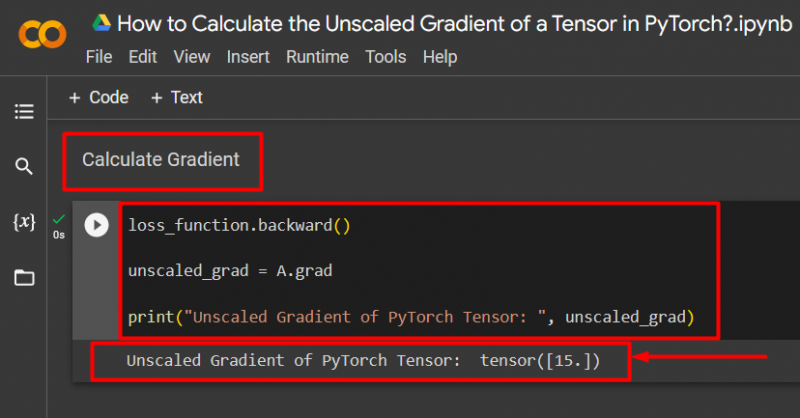

5단계: 그라데이션 계산 및 출력으로 인쇄

사용 ' 뒤로 ()” 메서드를 사용하여 다음과 같이 크기 조정되지 않은 그래디언트를 계산합니다.

loss_function.backward()unscaled_grad = A.grad

print('PyTorch Tensor의 크기 조정되지 않은 그라데이션: ', unscaled_grad)

위 코드는 다음과 같이 작동합니다.

- 사용 ' 뒤로 ()' 메서드를 사용하여 역방향 전파를 통해 크기 조정되지 않은 그래디언트를 계산합니다.

- '를 할당합니다. A.grad ' 로 ' unscaled_grad ” 변수입니다.

- 마지막으로 “ 인쇄 ()' 메서드를 사용하여 크기 조정되지 않은 그래디언트의 출력을 보여줍니다.

메모 : 여기에서 Colab Notebook에 액세스할 수 있습니다. 링크 .

전문가의 팁

텐서의 스케일링되지 않은 그래디언트는 PyTorch 프레임워크 내 신경망에 대한 손실 함수와 입력 데이터의 정확한 관계를 보여줄 수 있습니다. 편집되지 않은 원시 그라데이션은 두 값이 체계적으로 어떻게 관련되어 있는지 보여줍니다.

성공! 우리는 방금 PyTorch에서 텐서의 스케일되지 않은 그래디언트를 계산하는 방법을 보여주었습니다.

결론

먼저 텐서를 정의한 다음,ward() 메서드를 사용하여 기울기를 찾는 방식으로 PyTorch에서 텐서의 크기 조정되지 않은 기울기를 계산합니다. 이는 딥러닝 모델이 입력 데이터를 정의된 손실 함수와 어떻게 연관시키는지 보여줍니다. 이 블로그에서는 PyTorch에서 텐서의 스케일되지 않은 그래디언트를 계산하는 방법에 대한 단계별 튜토리얼을 제공했습니다.