머신러닝 모델의 적용 가능성과 유용성은 데이터를 대상으로 테스트됩니다. 테스트의 신뢰성은 이러한 모델이 적용되는 데이터의 양과 품질에 따라 크게 달라집니다. ' 자연어 처리 (NLP) ” 머신러닝 모델.

Hugging Face는 요구 사항에 완벽하게 맞는 데이터 세트를 선택하고 찾을 수 있는 매우 큰 데이터 세트 라이브러리를 통해 이를 위한 깔끔한 솔루션을 제공합니다. 여기에서는 이상적인 데이터 세트를 찾고 모델을 적절하게 테스트하기 위해 준비하는 방법을 보여줍니다.

포옹 얼굴 데이터 세트를 사용하는 방법은 무엇입니까?

'의 예를 사용하여 Hugging Face 데이터 세트를 사용하는 방법을 보여 드리겠습니다. 타이니스토리즈 ” Hugging Face의 데이터세트.

예

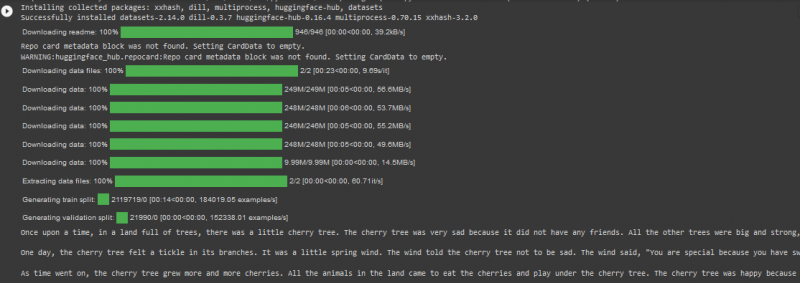

TinyStories 데이터 세트는 기차 분할에 200만 개 이상의 데이터 행을 보유하고 있으며 Hugging Face 플랫폼에서 2,000회 이상 다운로드되었습니다. 아래에 제공된 Google Colab의 코드에서 이를 사용합니다.

! 씨 설치하다 변압기

! 씨 설치하다 데이터세트

데이터 세트에서 import load_dataset

데이터 세트 = load_dataset ( '로네넬단/타이니스토리즈' )

TinyStories_스토리 = 삼

example_string = 데이터세트 [ '기차' ] [ 타이니스토리_스토리 ] [ '텍스트' ]

인쇄 ( 예_문자열 )

이 코드에서는 아래 명시된 단계를 고려하세요.

01단계 : 첫 번째 단계는 “ 설치 '변환기 데이터 세트.

02단계 : 다음으로 필요한 데이터세트를 가져옵니다. 타이니스토리즈 '를 프로젝트에 추가하세요.

03단계 : 다음으로 '를 사용하여 선택한 데이터세트를 로드합니다. 로드_데이터세트() ' 기능.

04단계 : 이제 TinyStories 데이터세트에서 원하는 스토리 번호를 지정합니다. 코드 예제에서는 숫자 03을 지정했습니다.

05단계 : 마지막으로 “print()” 메소드를 사용하여 출력을 표시하겠습니다.

산출

메모: 코드와 출력은 Google Colab에서 직접 볼 수도 있습니다. .

결론

“ 포옹하는 얼굴 데이터 세트 ” 사용자가 온라인 라이브러리에서 대규모 데이터 세트를 직접 가져오면서 기계 학습 모델을 테스트하는 것을 매우 효율적으로 만듭니다. 결과적으로 프로그래머가 품질과 수량을 모두 갖춘 데이터 세트에 대해 프로젝트를 테스트할 수 있게 되면서 NLP 알고리즘의 적용이 더 쉽고 빨라졌습니다.