빠른 개요

이 게시물에는 다음 섹션이 포함되어 있습니다.

LangChain에서 Async API 에이전트를 사용하는 방법은 무엇입니까?

채팅 모델은 프롬프트의 구조, 복잡성 이해, 정보 추출 등 여러 작업을 동시에 수행합니다. LangChain에서 Async API 에이전트를 사용하면 사용자는 한 번에 여러 질문에 답할 수 있는 효율적인 채팅 모델을 구축할 수 있습니다. LangChain에서 Async API 에이전트를 사용하는 프로세스를 알아보려면 다음 가이드를 따르세요.

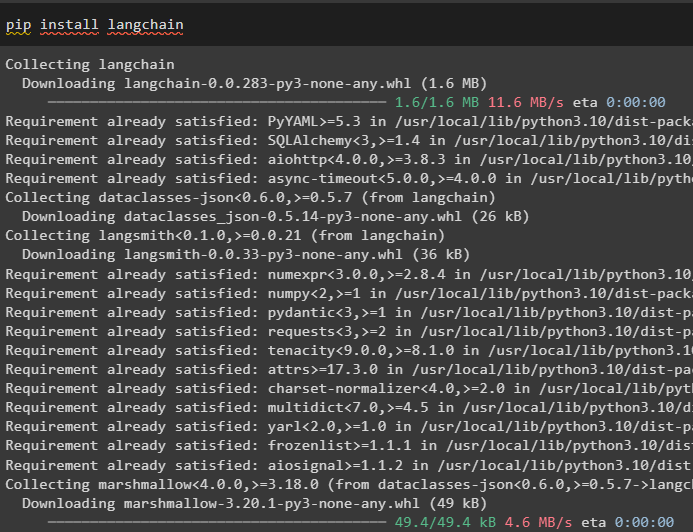

1단계: 프레임워크 설치

먼저 LangChain 프레임워크를 설치하여 Python 패키지 관리자에서 종속성을 가져옵니다.

pip 설치 랭체인

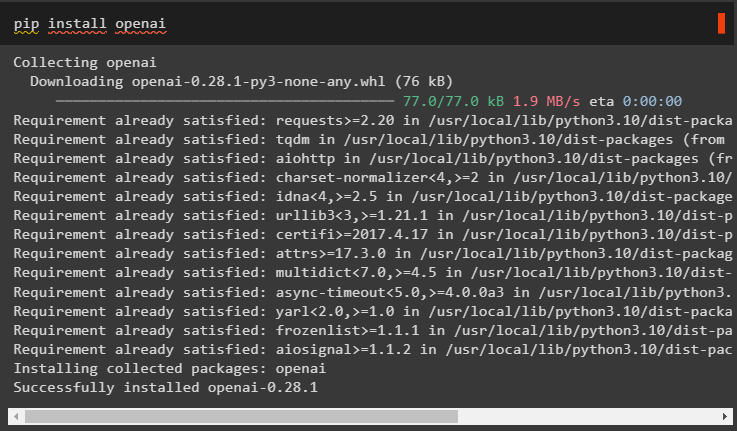

그런 다음 OpenAI 모듈을 설치하여 llm과 같은 언어 모델을 빌드하고 환경을 설정합니다.

pip 설치 openai

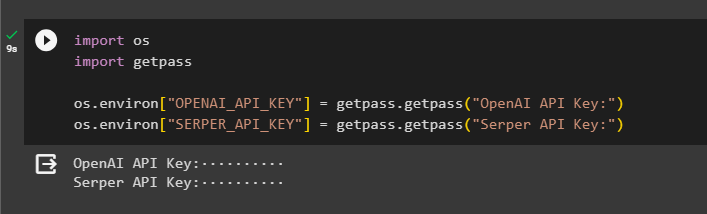

2단계: OpenAI 환경

모듈 설치 후 다음 단계는 다음과 같습니다. 환경 설정 OpenAI의 API 키를 사용하고 서버 API Google에서 데이터를 검색하려면:

수입 너

수입 getpass

너 . 약 [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'OpenAI API 키:' )

너 . 약 [ 'SERPER_API_KEY' ] = getpass . getpass ( 'Serper API 키:' )

3단계: 라이브러리 가져오기

이제 환경이 설정되었으므로 LangChain 종속성을 사용하여 asyncio 및 기타 라이브러리와 같은 필수 라이브러리를 가져오기만 하면 됩니다.

~에서 랭체인. 자치령 대표 수입 초기화_에이전트 , load_tools수입 시간

수입 비동기

~에서 랭체인. 자치령 대표 수입 에이전트 유형

~에서 랭체인. LLMS 수입 오픈AI

~에서 랭체인. 콜백 . 표준 출력 수입 StdOutCallbackHandler

~에서 랭체인. 콜백 . 추적자 수입 LangChain트레이서

~에서 아이오http 수입 클라이언트 세션

4단계: 설정 질문

인터넷(Google)에서 검색할 수 있는 다양한 도메인 또는 주제와 관련된 여러 쿼리가 포함된 질문 데이터세트를 설정합니다.

질문 = ['2021년 US오픈 우승자는 누구인가' ,

'올리비아 와일드 남자친구 나이는 몇 살이에요?' ,

'포뮬러1 월드 타이틀의 승자는 누구인가' ,

'2021년 US 오픈 여자 단식 결승 우승자는 누구?' ,

'비욘세의 남편은 누구이며 나이는 어떻게 됩니까?' ,

]

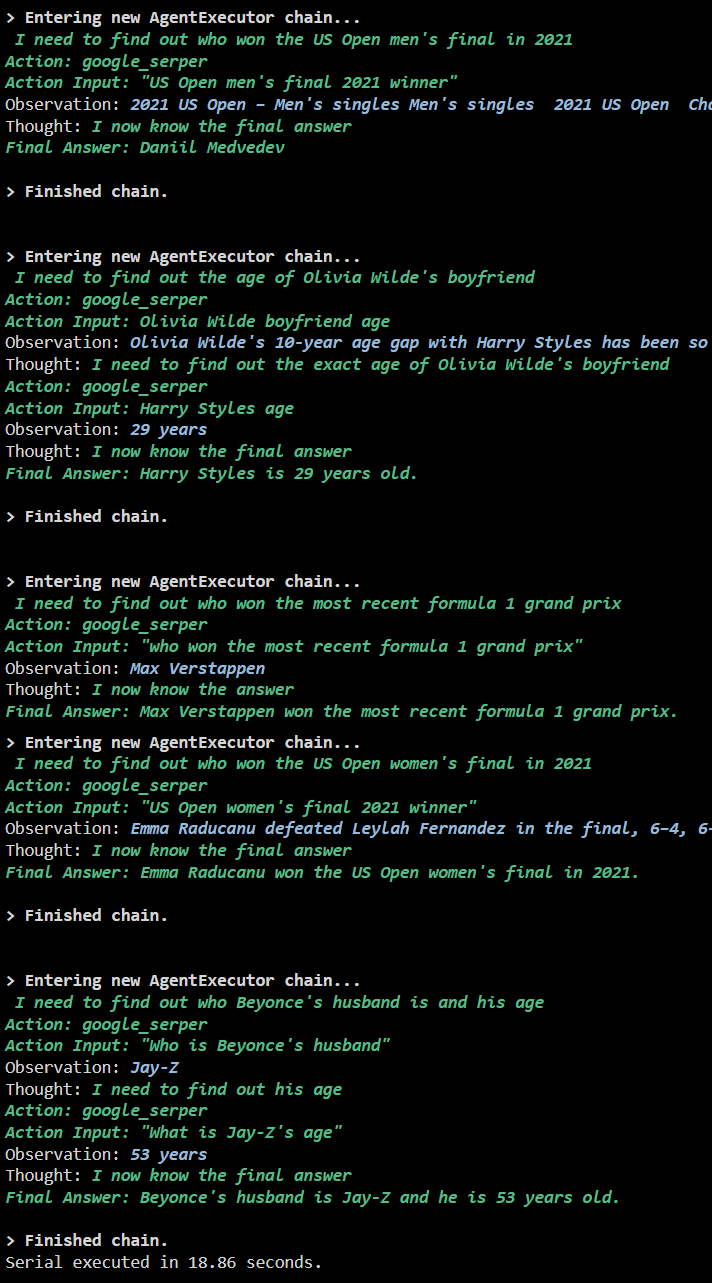

방법 1: 직렬 실행 사용

모든 단계가 완료되면 직렬 실행을 통해 질문을 실행하여 모든 답변을 얻으세요. 이는 한 번에 하나의 질문이 실행/표시되며 이러한 질문을 실행하는 데 걸리는 전체 시간도 반환한다는 의미입니다.

ㅋㅋㅋ = 오픈AI ( 온도 = 0 )도구 = load_tools ( [ '구글 헤더' , 'llm-수학' ] , ㅋㅋㅋ = ㅋㅋㅋ )

대리인 = 초기화_에이전트 (

도구 , ㅋㅋㅋ , 대리인 = 에이전트 유형. ZERO_SHOT_REACT_DESCRIPTION , 말 수가 많은 = 진실

)

에스 = 시간 . 성능 카운터 ( )

#전체 프로세스에 사용된 시간을 가져오기 위해 시간 카운터 구성

~을 위한 큐 ~에 질문:

대리인. 달리다 ( 큐 )

경과 = 시간 . 성능 카운터 ( ) - s

#에이전트가 답변을 얻기 위해 사용한 총 시간을 인쇄합니다.

인쇄 ( 에프 '{elapsed:0.2f}초 후에 직렬이 실행되었습니다.' )

산출

다음 스크린샷에는 각 질문에 대한 답변이 별도의 체인으로 표시되어 있으며 첫 번째 체인이 완료되면 두 번째 체인이 활성화됩니다. 직렬 실행은 모든 답변을 개별적으로 얻는 데 더 많은 시간이 걸립니다.

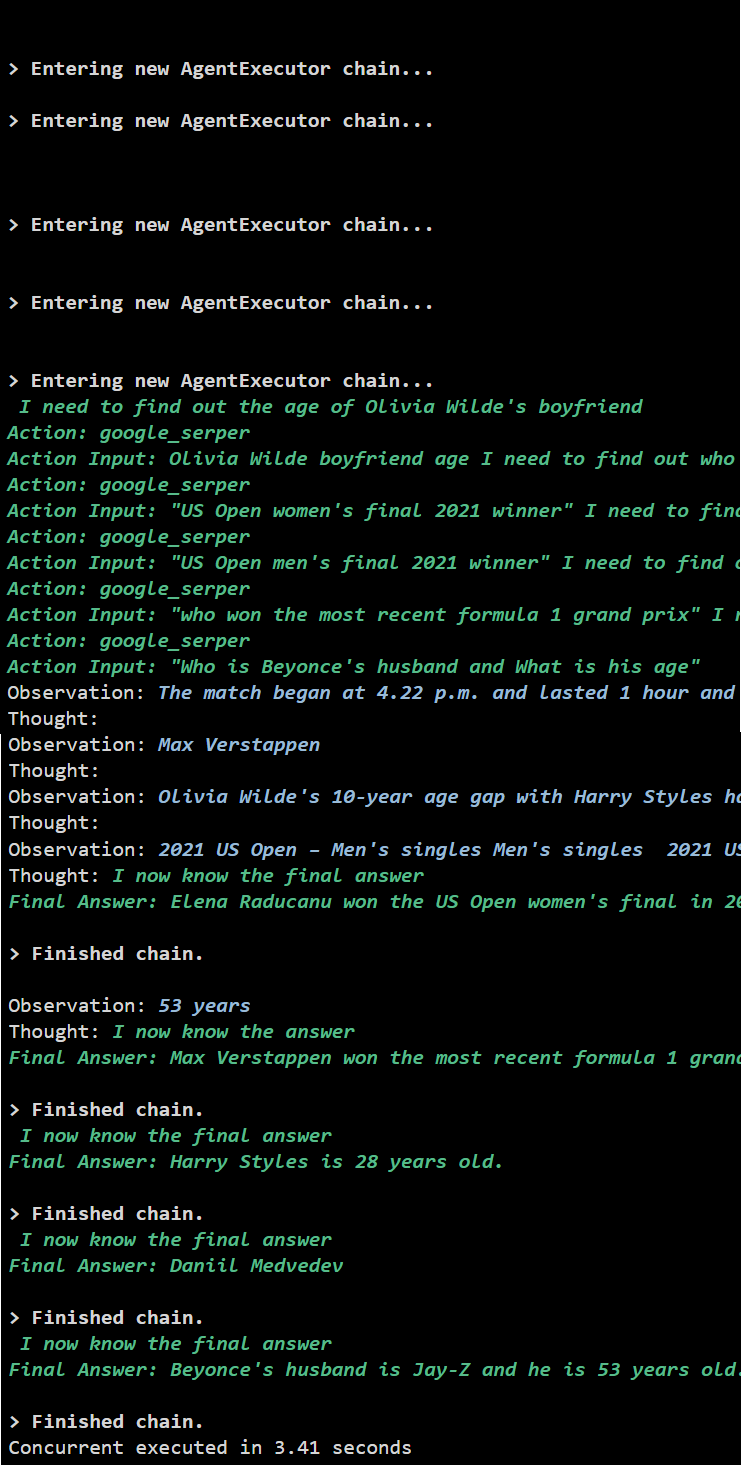

방법 2: 동시 실행 사용

동시 실행 방법은 모든 질문을 받아 동시에 답변을 얻습니다.

ㅋㅋㅋ = 오픈AI ( 온도 = 0 )도구 = load_tools ( [ '구글 헤더' , 'llm-수학' ] , ㅋㅋㅋ = ㅋㅋㅋ )

#위 도구를 사용하여 동시에 답변을 얻을 수 있는 에이전트 구성

대리인 = 초기화_에이전트 (

도구 , ㅋㅋㅋ , 대리인 = 에이전트 유형. ZERO_SHOT_REACT_DESCRIPTION , 말 수가 많은 = 진실

)

#전체 프로세스에 사용된 시간을 가져오기 위해 시간 카운터 구성

에스 = 시간 . 성능 카운터 ( )

작업 = [ 대리인. 질병 ( 큐 ) ~을 위한 큐 ~에 질문 ]

비동기를 기다리세요. 모으다 ( *과제 )

경과 = 시간 . 성능 카운터 ( ) - s

#에이전트가 답변을 얻기 위해 사용한 총 시간을 인쇄합니다.

인쇄 ( 에프 '{경과:0.2f}초 내에 동시 실행됨' )

산출

동시 실행은 모든 데이터를 동시에 추출하며 직렬 실행보다 시간이 훨씬 적게 걸립니다.

이것이 바로 LangChain에서 Async API 에이전트를 사용하는 것에 관한 것입니다.

결론

LangChain에서 Async API 에이전트를 사용하려면 모듈을 설치하여 해당 종속성에서 라이브러리를 가져와 asyncio 라이브러리를 얻으세요. 그런 다음 해당 계정에 로그인하여 OpenAI 및 Serper API 키를 사용하여 환경을 설정하십시오. 다양한 주제와 관련된 일련의 질문을 구성하고 체인을 직렬 및 동시에 실행하여 실행 시간을 얻습니다. 이 가이드는 LangChain에서 Async API 에이전트를 사용하는 과정을 자세히 설명했습니다.